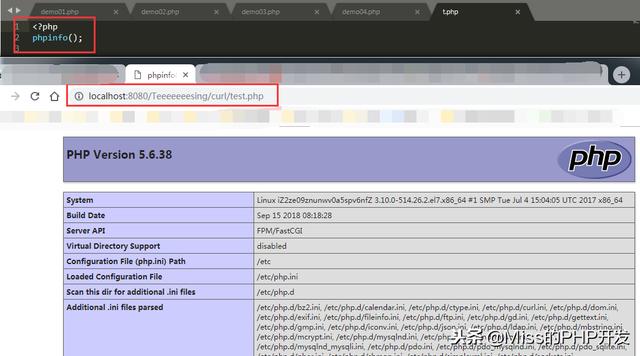

文章前提:自己的练习环境支持curl,自己配置

一、cURL的概念

- cURL(client URL Library Functions)使用URL语法传输数据的命令行工具。

- CURL是一个非常强大的开源库,支持很多协议,包括HTTP、FTP、 TELNET 等,我们使用它来发送HTTP请求。它给我 们带来的好处是可以通过灵活的选项设置不同的HTTP协议参数,并且支持 https 。CURL可以根据URL前缀是“HTTP” 还是“HTTPS”自动选择是否加密发送内容。

二、cURL的使用场景

- 网页资源

网页 爬虫 。

- WebService 数据接口资源

动态获取接口数据,比如天气,号码归属地等等。

- FTP服务器里面的文件资源

下载FTP服务器里面的文件。

- 其他资源

所有网络上的资源都可以用cURL访问和下载到。

三、实战

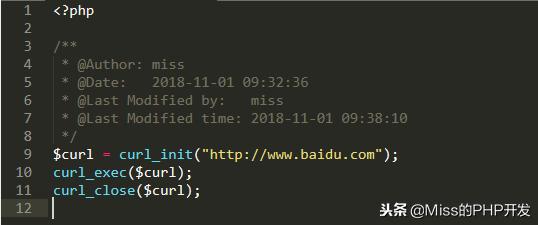

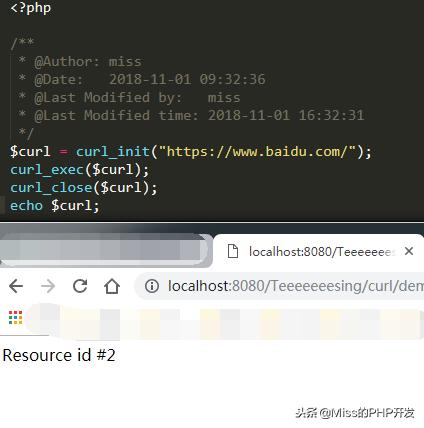

1.网络爬虫

初级版: 爬网页

运行代码直接弹出爬取的页面,如下:

(http网页和https网页的爬取有区别,大家可以先测试一下)

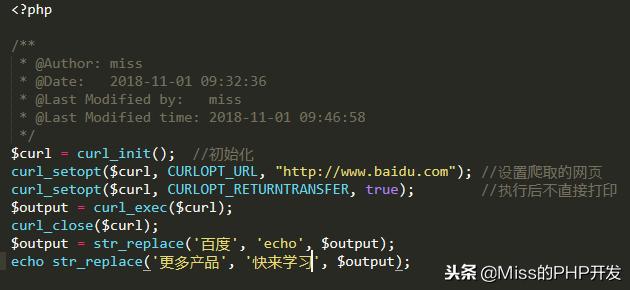

升级版: (替换文字)

str_replace()

替换后的结果:

2、通过cURL访问WebService

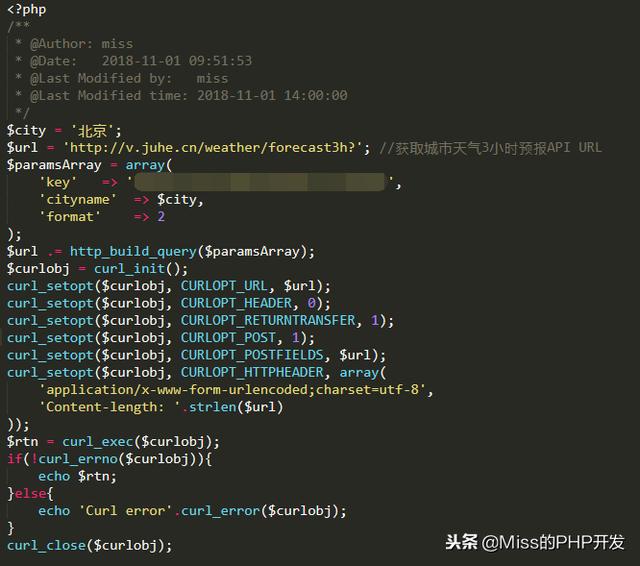

抓取天气数据WeatherWS:

或者 聚合数据 :

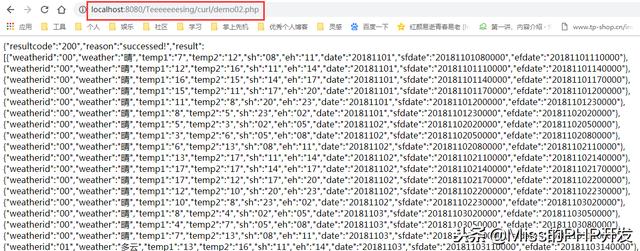

调用结果:

3、模拟登陆(根据网站不同,参数进行变化)

效果为: 登陆页模拟登陆无误后跳转至首页。

4、从FTP下载文件到本地

文件内容以及打印结果:

5、从本地上传文件到FTP

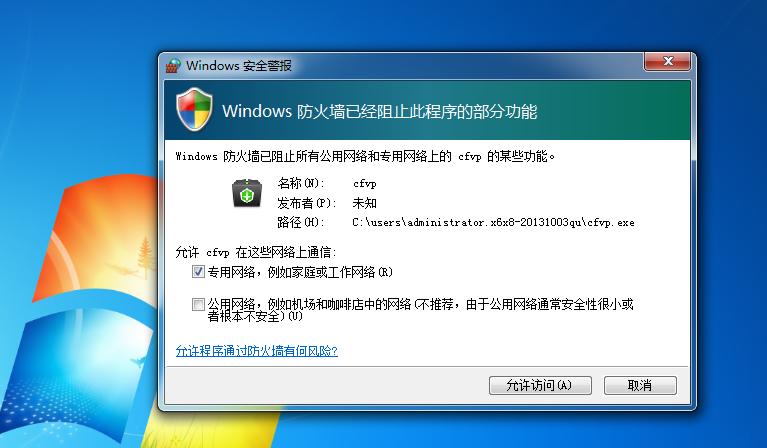

6、cURL访问HTTPS数据

访问https网站的结果:

不处理抓取HTTPS网页(无法抓取):

同样方法抓取HTTP网页,没有问题,所以HTTPS的网页需要进行处理才可正常抓取。

海报

191