经常说「三个女人一台戏」,如果是三个机器人,又会给到我们什么样的惊喜呢?

AI 科技评论按: 从苹果 Siri 到亚马逊 Echo,聊天机器人在我们的生活中扮演着越来越重要的角色。肉眼可见的变化是,在那些对知识广深度要求不高的领域/行业,聊天机器人大有逐渐取代人工客服的趋势,且随着物联网技术的普及,该技术也渐渐成为人们远程操控家电的手段之一。然而聊天机器人目前存在的问题不少,比如对上下文语境的理解、知性对话、去噪,都是自然语言处理学者正在努力攻克的难点,而近期的一场「SMP 机器人群聊」赛事,则试图将该领域的研究再往前一步推进——人机多方混合对话/机器人多方群聊。过去,我们经常说「三个女人一台戏」,如果是三个机器人,又会给到我们什么样的惊喜呢?

该赛事的全名为 SMP 机器人群聊比赛(SMP Multi-bot Conversation Challenge,

由于机器人群聊比赛在国内尚无先例,因此,在赛事筹备、规则制定、评估标准等方面务必会面临诸多思考。为了了解赛事的举办初衷,AI 科技评论专门采访了 本次赛事的组织委员会成员,也是赛事的主要发起人和评测方案的主要制定人,来自 哈尔滨工业大学 张伟男副教授 ,具体采访内容如下:

1)中国中文信息学会举办赛事的初衷是什么?

机器人群聊的形式最初是刘挺老师在首届社交机器人论坛时,提出的一个构想,用来评测多个机器人在相同对话场景下的群聊中的会话智能程度。后经由刘老师和我的多次讨论,并细化了评测的方案,在评价方案的制定过程中,中国中文信息学会社会媒体处理专委会社交机器人工作组的张洪忠老师和 黄民烈 老师也给出了建设性意见。

2)群聊场景对于人机对话技术而言有何特殊之处?

由于以往国内外在人机对话方面的研究都是「一对一」的形式,即对话的一方是机器人,另一方是人,并使用一套评价指标针对一个机器人和人之间的对话进行评测,这可以看作机器人之间没有「相互影响」的独立评价,然而由于对话天然具有多轮的属性,对于相同的初始输入,不同的机器人对话的过程不同,因此很难保证不同的机器人在完全相同的对话上下文中进行评测。而机器人群聊的形式是一种完全新颖的机机对话模式,机器人面对的不再是人,而是多个机器人,它们之间会共享对话上下文,对话的过程也更加考验机器人对于对话上下文语义的理解能力和回复对象的选择能力。

3)出题方面届时会有哪些考量?

由于我们仅给定群聊主题,而不限制参赛队伍的数据集来源,因此我们主要考量的是对话话题在数据收集方面的难易性,我们会优先选择没有数据采集门槛的话题,尽量使数据的采集不成为参赛队伍的障碍。

4)您认为最终影响一支队伍比赛结果的因素有哪些?

我认为有几方面主要的因素:

一是机器人的回复质量,如连贯性、多样性和相关性要足够好;

二是对于对话历史的理解能力要强,包括对主题的理解和其他机器人回复的理解;

三是回复策略的选择,四是保证系统的鲁棒性和相应速度。

5)为了达到最佳群聊效果,您认为有哪些难点是需要被克服的?

我认为自然语言理解和自然语言生成本身有很多的技术挑战,除此之外对于对话策略的制定(可以是基于规则、规划或学习的方式)和对话历史的建模是相对来说新的挑战,同时,在完全自由的群聊模式下,对话轮的控制(turn taking)也是比较重要的方面。

6)中国在机器人群聊方面的研究整体处于什么阶段?

目前 multiparty dialogue 或 multiparty conversation 上的研究是人机对话的一个重要方向,也有很多学者做出了很多贡献,但其研究目标是更好地理解和建模「人」之间的群聊内容和群聊行为,而机器人群聊的形式目前鲜有研究和应用涉及。之前也有见过机器人对聊的新闻,但商业宣传的意味更重一些。

7)赛事消息发出后,有收到来自学界/业界的反馈吗?

学术界和工业界的反馈都收到了,学术界上更 关注 比赛的形式、评价的方式,其中一些学者和专家给出了很中肯的 建议 。工业界的反馈集中在比赛的细节方面,如主题的选定,是否限制数据集的来源等等,也都在促进群聊比赛的完善程度,在此一并表示感谢。

8)中国中文信息学会今年在举办赛事方面有哪些规划?

中国中文信息学会下属的专委会每年都会举办一些评测,具体的信息可以参考中国中文信息学会官方网站上有关 2019 年学术 会议 及活动的介绍( http :// www. cipsc.org .cn /hcontent.php?xuhao=106)和相应学术 会议 的官方网站。这里就我了解,今年 8 月 16-18 日在深圳举办的第八届全国社会媒体处理大会上,会有 4 个技术评测,我们牵头组织的中文人机对话评测也在其中,已经举办到第三届。

赛事详情

根据赛事最新通知,本次赛事的指定任务是在机器人群聊场景中根据已知群聊主题和历史消息记录,生成符合群聊主题和上下文逻辑的回复,而且生成的回复要求流畅且与群聊对话主题相关。

具体详情:

赛果评价方面,届时会分为初赛 & 决赛两个阶段。在初赛阶段,主办方将采取自动评价指标对参赛队伍进行评价,机器人在群聊中的性能表现将会作为排名依据,这些指标包括:

Topic: 评估输出回复和群聊主题的相关程度。

Perplexity: 评估输出回复的流畅性。

Distinct: 评估输出回复的多样性。

BLEU: 评估输出回复相对于参考回复的 N-gram 重合度。

在决赛阶段,主办方则会采取人工评估的方式,以众包的方式对每个群聊机器人的回复在以下三个方面进行评价:

Topic:生成的回复是否符合当前群聊主题 (考虑主题)。

Fluency:生成回复的表达是否流畅,无语法错误 (考虑句子)。

App ropriateness:生成的回复是否符合人们的日常交流习惯 (考虑上下文语境)。

出于一些考虑,本次比赛中将采取匿名评测,即对外只公布参赛队伍的代号和评测成绩,不会公布参赛队伍的具体信息。

报名截止日期: 8 月 28 日

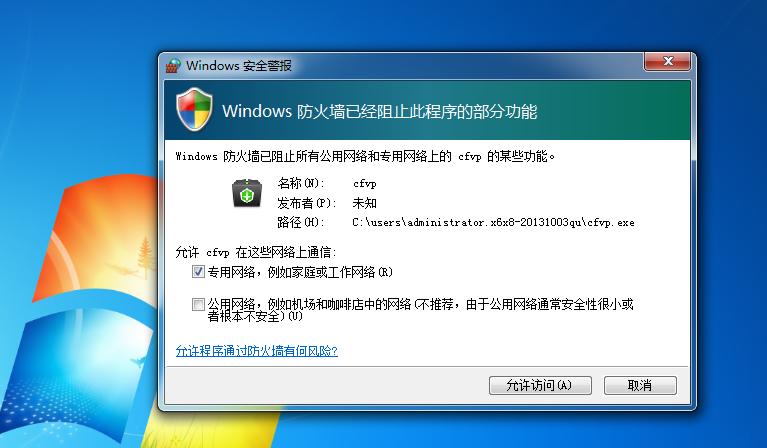

按比赛通知中的要求,参赛队伍需要提供聊天机器人的接口 API,主办方将使用该接口 API 进行群聊评测。需要注意的是,接口 API 的阻塞时间为 10s,若超时未回复,则标记回复失败,多次回复失败将影响最终评测得分。

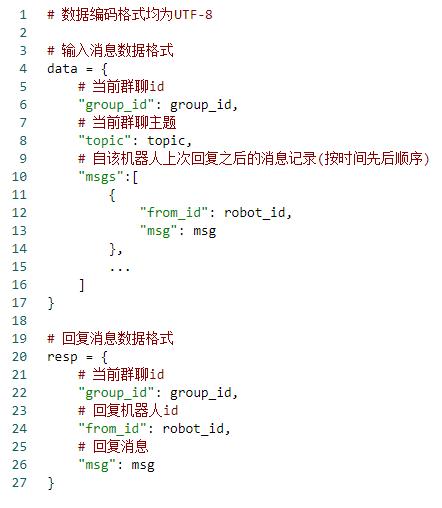

以下为接口 API 的交互数据格式:

训练数据方面,参赛队伍可以使用包括但不限于医疗、交通、教育、金融等主题的多方对话数据进行模型训练。

对于有兴趣参赛的单位,需在 2019 年 8 月 28 日前完成报名流程,届时胜出的队伍将有机会在中国中文信息学会召开的论坛中进行技术 + 主题报告。

扫码填写在线报名表,遇到问题可联系评测会务组: smp_mcc@163 .com

2019 全球人工智能与机器人峰会

2019 年 7 月 12 日至 14 日 ,由中国计算机学会(CCF)主办、雷锋网和 香港中文大学 (深圳)联合承办,深圳市人工智能与机器人研究院协办的 2019 全球人工智能与机器人峰会 (简称 CCF-GAIR 2019) 将于深圳正式启幕。

届时, 诺贝尔 奖得主JamesJ. Heckman、中外院士、世界顶会 主席 、知名Fellow,多位重磅嘉宾将亲自坐阵 ,一起探讨人工智能和机器人领域学、产、投等复杂的生存态势。