大数据中损失函数的正则化

大数据中损失函数的正则化

这篇文章将为大家详细讲解有关大数据中损失函数的正则化,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。

损失函数的正则化

范数(Norm):用来度量某个向量空间(或矩阵)中每个向量的长度或大小。

向量范数——L1和L2最常用

矩阵范数

线性回归的正则化

使用训练集拟合线性回归方程时,如使用多项式拟合时,一般来说拟合方程的次数越高拟合效果越好,损失函数越小,但拟合函数也变得更加复杂。

在某些异常的情况下,如训练的数据量较小或者特征过多时,测试集中如果出现先前训练集中没有的样本,预测结果未必有效,使得分类结果的方差较大,出现过拟合,由此可见损失函数过小也不可取,意味着模型的通用性不够,即需要提高泛化能力,因而加上正则化项。此处正则化参数的标识是α,有些资料中会显示为λ,因为在sklearn库中,此项参数的标识为α,为方便使用,标识采用α。

线性回归正则化后的梯度更新方法

与线性回归的梯度更新公式相同,当θk等于θj时,可以对式子求导,得到新的梯度更新公式。

为什么要使用正则化?

为什么

为什么要对回归使用正则化?

为加强对正则化的理解,举例说明回归为什么要正则化-Regularization

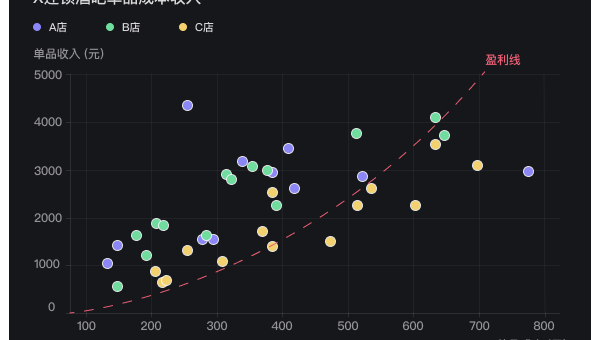

多项式的次数提高,对于拟合性能的提升不大。

当把训练样本数从500降低至498时,发现高次多项式对于拟合的效果反而下降,对数据的预测能力下降,出现过拟合的现象。

正则化的基本方法是将所有多项式的系数的绝对值之和-L1正则化,或者多项式的系数绝对值的平方和再开方-L2正则化加入到惩罚项中,并制定一个惩罚力度因子来避免产生畸形的系数;即通过使用Lasso回归-采取L1正则化,岭回归-采取L2正则化,或者弹性网回归-L1+L2正则化来降低过拟合。上面通过举例使用岭回归,可以发现模型克服了100次多项式带来的过拟合问题。

岭回归中正则权重的作用

正则强度α是正则化系数或惩罚力度因子,weights权重系数是回归方程中的系数,一条不同颜色的曲线代表权重系数向量的一个不同的分量。α往左越大,往右趋向于0,因此可以α可以对权重系数进行约束。

通过交叉验证找到最佳超参数α

交叉验证Cross Validation 是将训练集分成几份,分别用来训练,测试和验证,以寻找到最佳的超参数,在程序中设置好一组alpha后,程序可自行验证并返回最佳的alpha。

关于“大数据中损失函数的正则化”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,使各位可以学到更多知识,如果觉得文章不错,请把它分享出去让更多的人看到。

推荐阅读

-

如何理解处女座在数据整理中的精确

-

Linux如何安装和使用 Hadoop 大数据框架

-

RStudio 数据分析全流程:从数据导入到动态报告生成的最佳实践

-

教育领域编程教学:Jupyter Notebook 与 RStudio 在数据分析课程中的应用

-

JUnit 5 参数化测试:数据驱动测试的实现与最佳实践

-

RStudio 数据可视化:ggplot2 与交互式图表制作全流程

-

Jupyter Notebook 魔法命令:提升数据分析效率的 20 个技巧

-

如何高效地在多台服务器上均匀分布海量键?

在多台服务器上均匀分布海量键的挑战在分布式系统中,当需要将大量数据键映射到多个服务器时,保证数据均匀分布至关重要。尤其是在需要对...

-

分布式集群中如何保证数据均匀分布?

-

Linux上Swagger UI展示效果优化方法