Jupyter Notebook 性能优化:内核管理与大文件处理技巧

Jupyter Notebook性能优化指南:高效内核管理与大文件处理技巧

在数据分析和机器学习领域,Jupyter Notebook凭借其交互式编程的优势,成为许多开发者的首选工具。然而,随着项目规模的扩大和数据量的增加,Jupyter Notebook的性能问题日益凸显。如何优化Jupyter Notebook的性能,提升开发效率,成为每个开发者都需要面对的挑战。本文将从内核管理和大文件处理两个方面,分享实用的性能优化技巧。

一、优化内核管理,释放计算资源

合理选择内核类型根据项目需求选择合适的内核类型。对于需要大量计算任务的项目,可以考虑使用GPU加速的内核;而对于简单的数据分析任务,选择轻量级的CPU内核即可。合理分配内核资源,避免资源浪费。

管理多个内核长期运行的Jupyter Notebook容易产生多个僵尸内核,占用不必要的系统资源。定期清理不必要的内核,可以通过Jupyter Notebook的界面直接删除不再使用的内核。

配置内核启动参数根据项目需求调整内核的启动参数,如内存限制、线程数等。避免内核占用过多系统资源,影响其他程序的运行。

二、内存优化:让数据处理更高效

使用内存分析工具安装memory_profiler等内存分析工具,实时监控内存使用情况,及时发现内存泄漏问题。

优化数据结构根据数据特点选择合适的数据结构,避免不必要的数据复制。对于大数据处理,可以考虑使用Dask等分布式计算框架。

分块处理数据对于超大文件,采用分块处理的方式,逐块读取和处理数据,避免一次性加载全部数据导致内存溢出。

三、大文件处理技巧

数据预处理在读取大文件之前,先进行数据预处理,过滤掉不需要的字段或记录,减少后续处理的数据量。

使用高效的数据格式将数据存储为Parquet、HDF5等列式存储格式,提高数据读取速度和内存利用率。

分布式计算框架对于超大文件,可以考虑使用Spark等分布式计算框架进行处理,充分利用集群资源。

四、借助扩展工具提升效率

使用JupyterLabJupyterLab提供更强大的文件管理功能,支持多窗口同时操作,提升开发效率。

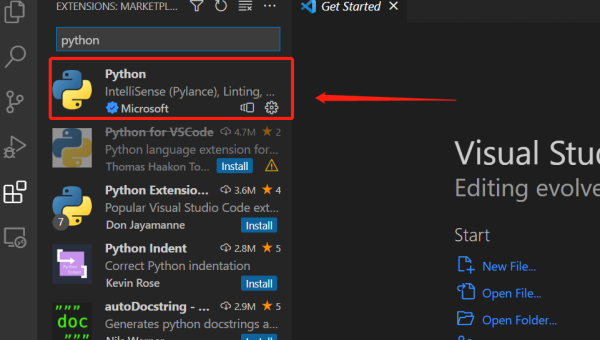

安装性能优化插件安装jupyter_contrib_nbextensions等插件,获得更多的功能扩展,如代码折叠、快速运行等。

使用nbstripout清理输出定期清理Notebook中的输出内容,减少文件体积,提升运行速度。

通过以上优化方法,可以有效提升Jupyter Notebook的性能,让数据处理更加高效流畅。在实际开发中,需要根据具体项目需求,灵活运用这些技巧,找到最适合自己的优化方案。希望这些方法能帮助你更好地发挥Jupyter Notebook的强大功能,提升开发效率。

推荐阅读

-

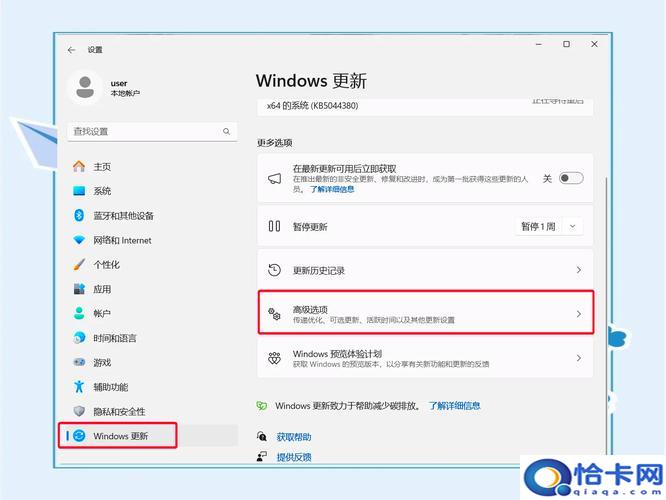

如何加快电脑运行速度?有效优化技巧推荐

-

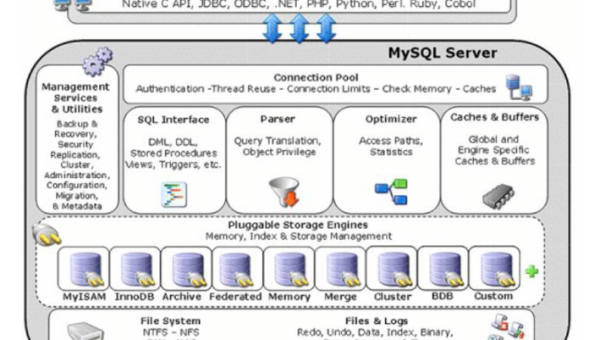

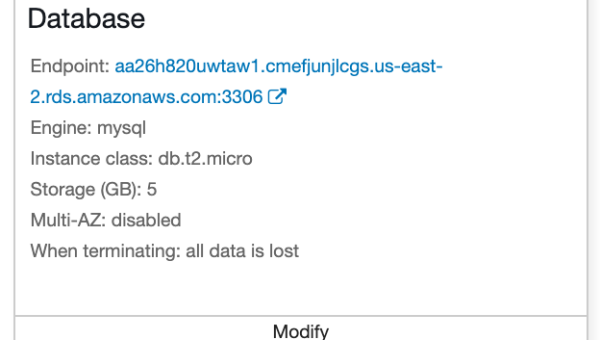

Retool 数据库连接:支持 MySQL、PostgreSQL 等多数据源配置

-

Jupyter Notebook 多人协作:实时编辑与版本控制方案

-

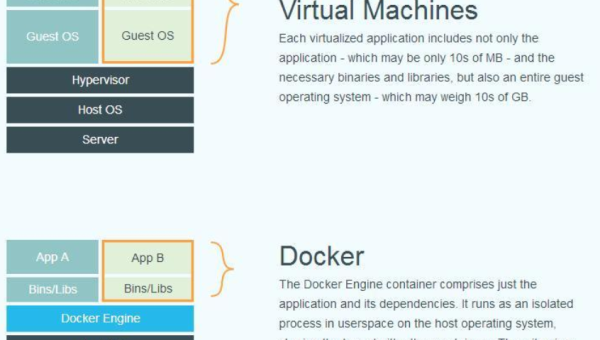

Docker 数据卷管理:持久化存储与容器间数据共享

-

Atom 性能优化:禁用冗余包与内存泄漏检测工具使用

-

AWS Elastic Beanstalk 环境迁移:跨区域部署与数据同步方案

-

Git LFS 大文件存储:音视频资源版本控制与性能优化

-

Vim 可视化块模式:列编辑与表格数据处理的终极技巧

-

PyCharm 远程解释器配置:连接 Jupyter Kernel 与服务器环境同步

-

如何理解处女座在数据整理中的精确