Kubernetes Horizontal Pod Autoscaler:CPU / 内存指标调优策略

Kubernetes Horizontal Pod Autoscaler:CPU / 内存指标调优策略

在 Kubernetes 的世界中,Horizontal Pod Autoscaler(HPA)是一个强大的工具,能够根据应用的负载自动调整 Pod 的数量。然而,要让 HPA 真正发挥作用,合理设置 CPU 和内存的指标调优策略至关重要。本文将深入探讨如何优化 HPA 的 CPU 和内存指标,帮助你更好地管理 Kubernetes 集群的资源利用效率。

一、理解 HPA 的基本原理

HPA 的核心目标是通过监控应用的资源使用情况,动态调整 Pod 的数量,以满足服务需求的同时避免资源浪费。HPA 会根据设定的指标(如 CPU 利用率、内存使用量)来判断是否需要扩缩容。默认情况下,HPA 会关注 CPU 利用率,但也可以通过配置来监控内存或其他自定义指标。

二、CPU 指标的调优策略

合理设置目标利用率

HPA 的 CPU 目标利用率决定了 Pod 在什么情况下会被扩缩容。通常,建议将目标利用率设置在 50% 到 80% 之间。过低的目标利用率可能导致频繁的扩缩容操作,增加资源浪费;过高的目标利用率则可能引发服务延迟。- 动态调整:根据应用的负载特性,动态调整目标利用率。例如,对于波动较大的应用,可以适当提高目标利用率,减少扩缩容的频率。

- 监控与分析:使用 Kubernetes 的监控工具(如 Prometheus、Grafana)分析 CPU 的使用趋势,帮助你找到最佳的目标利用率。

避免 CPU 利用率的波动

CPU 利用率的波动可能会影响 HPA 的判断。为了避免这种情况:- 确保应用的负载分布均匀,避免短时间内出现剧烈波动。

- 使用 HPA 的

scaleDown策略,避免在低负载时过快缩容。

结合其他指标

CPU 利用率并不是唯一的参考指标。如果应用的 CPU 使用量较低,但内存或其他资源使用量较高,单纯依赖 CPU 利用率可能导致扩缩容决策失误。因此,建议结合内存或其他自定义指标进行综合判断。

三、内存指标的调优策略

内存利用率的特殊性

内存与 CPU 不同,内存的使用量通常不会像 CPU 那样波动。因此,HPA 的内存指标调优需要更加谨慎。建议将内存目标利用率设置在 60% 到 80% 之间。避免内存泄漏问题

如果应用存在内存泄漏问题,HPA 可能会错误地认为需要扩缩容。因此,在配置内存指标时,务必确保应用的内存管理是健康的。结合 eviction 机制

Kubernetes 提供了内存 eviction 机制,当 Pod 的内存使用量超过一定阈值时,会触发驱逐策略。合理配置 eviction 机制,可以与 HPA 配合使用,避免资源耗尽导致服务中断。

四、HPA 调优的综合策略

监控与分析

使用 Kubernetes 的监控工具(如 Prometheus、Metrics Server)实时监控 CPU 和内存的使用情况,分析 HPA 的扩缩容行为是否符合预期。逐步调整

不要一次性将目标利用率调整到极限值,而是逐步调整,观察 HPA 的反应。例如,先将目标利用率设置在 60%,运行一段时间后,再调整到 70%。结合其他 Autoscaler

HPA 可以与其他 Autoscaler(如 Cluster Autoscaler)配合使用,实现更全面的资源管理。例如,当 HPA 无法满足负载需求时,Cluster Autoscaler 可以自动扩展节点数量。

五、常见问题及解决方案

资源利用率忽高忽低

- 原因:应用负载波动较大,或 HPA 的目标利用率设置不合理。

- 解决:适当提高目标利用率,减少扩缩容的频率。

HPA 调整过于频繁

- 原因:目标利用率设置过低,或监控数据不够稳定。

- 解决:增加 HPA 的

scaleUp和scaleDown的冷却时间,避免频繁调整。

内存指标不起作用

- 原因:内存指标配置错误,或 Kubernetes 版本不支持内存指标。

- 解决:检查内存指标的配置,确保 Kubernetes 版本支持内存指标。

六、总结

Kubernetes 的 HPA 是一个强大的工具,但它的效果取决于合理的指标调优策略。通过科学设置 CPU 和内存的目标利用率,结合监控工具和 eviction 机制,可以显著提升 HPA 的性能和稳定性。希望本文的调优策略能够帮助你更好地管理 Kubernetes 集群,实现资源的高效利用。

推荐阅读

-

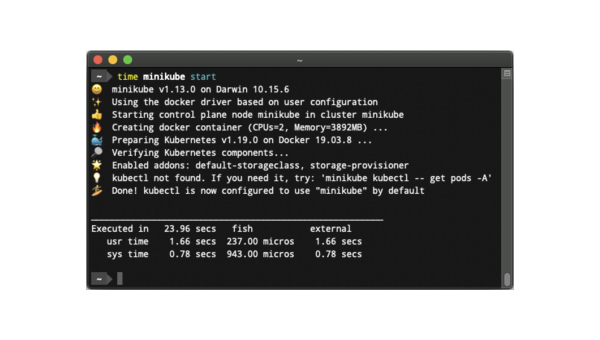

Linux怎么安装和使用Minikube搭建Kubernetes集群

-

Kubernetes 网络策略:Pod 间通信控制与安全隔离配置

-

Node.js 微服务部署:Kubernetes 自动扩缩容配置实战

-

Kubernetes 资源配额:CPU 与内存限制的集群管理策略

-

Xcode 模拟器性能监控:CPU / 内存占用分析与卡顿问题定位

-

Kubernetes 服务网格:Istio 与 Linkerd 的选型对比与实践

-

Kubernetes 存储类(StorageClass):动态卷供给与性能优化

-

Kubernetes 网络策略实战:基于标签的 Pod 间通信控制

-

Kubernetes 自定义资源定义(CRD):扩展集群功能的实战案例

-

Linux怎样设置系统对特定进程的资源限制