Kubernetes 资源配额:CPU 与内存限制的集群管理策略

随着容器化技术的普及,Kubernetes作为最流行的容器编排平台,已经成为企业构建和管理容器化应用的核心工具。然而,随着集群规模的不断扩大和应用数量的增加,资源管理问题逐渐凸显。如何合理分配和限制CPU与内存资源,成为了 Kubernetes 集群管理中的关键挑战。本文将围绕 Kubernetes 的资源配额管理,探讨 CPU 和内存限制的最佳实践,帮助企业优化资源利用率,提升应用性能。

为什么需要资源配额?

在 Kubernetes 集群中,资源争用是一个常见的问题。如果没有合理的配额限制,某些应用可能会占用过多的 CPU 或内存资源,导致其他应用性能下降甚至崩溃。此外,资源浪费也是一个不容忽视的问题。例如,某些应用可能申请了远超实际需求的资源,而这些资源却长期处于闲置状态,导致集群资源利用率低下。

资源配额的作用在于为每个应用或命名空间设定资源使用上限,确保每个组件都能在公平的环境中运行。通过合理的配额管理,可以避免资源争用,提升集群的整体稳定性。

CPU与内存限制的实施策略

1. 理解资源请求与限制

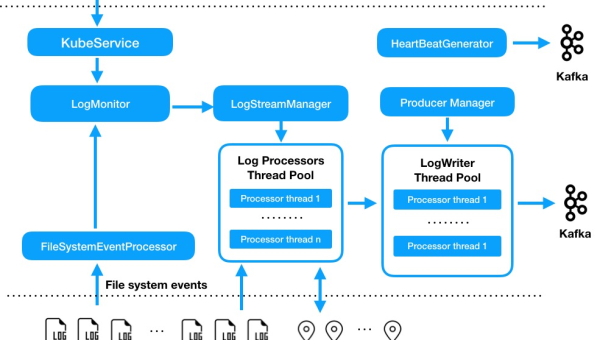

在 Kubernetes 中,资源管理主要通过 requests 和 limits 两个参数来实现。requests 是应用期望获得的资源量,而 limits 是应用可以使用的资源上限。合理设置这两个参数是资源配额管理的基础。

- CPU 请求与限制:CPU 资源以核心数为单位,例如

100m表示 0.1 核心。设置 CPU 请求可以帮助调度器更好地安排 Pod,而 CPU 限制则可以防止单个 Pod 占用过多 CPU 资源。 - 内存请求与限制:内存资源以字节为单位,例如

512Mi表示 512 兆字节。内存限制可以防止 Pod 因内存泄漏或突增而耗尽集群资源。

2. 命名空间级别的配额管理

Kubernetes 提供了命名空间级别的资源配额功能,管理员可以根据业务需求为每个命名空间设置 CPU 和内存的使用上限。例如,可以为开发、测试和生产环境分别设置不同的配额,确保关键业务的资源供应。

通过 ResourceQuota 对象,可以限制命名空间中 Pod、Service、PersistentVolumeClaim 等资源的使用数量和容量。例如,以下配置可以限制一个命名空间的 CPU 和内存使用:

apiVersion: v1kind: ResourceQuotametadata: name: example-quotaspec: hard: requests.cpu: "2" requests.memory: "4Gi" limits.cpu: "4" limits.memory: "8Gi"3. 实时监控与调整

资源配额的设置并非一劳永逸,需要根据实际运行情况动态调整。通过 Kubernetes 的监控工具(如 Prometheus 和 Grafana),可以实时查看集群中各组件的资源使用情况。如果发现某些应用长期接近或超过配额限制,可能需要重新评估资源需求,调整配额设置。

此外,Kubernetes 的自动扩缩容功能(如 Horizontal Pod Autoscaler 和 Cluster Autoscaler)也可以与资源配额结合使用,进一步优化资源利用率。

常见问题及解决方案

1. 资源不足与过载

在实际运行中,可能会遇到资源不足的问题。例如,某个命名空间的 CPU 使用量长期接近配额上限,导致新 Pod 无法调度。此时,可以考虑以下解决方案:

- 增加配额:如果业务需求确实需要更多资源,可以适当提高配额限制。

- 优化应用:通过优化代码或架构设计,减少资源消耗。

- 扩展现有集群:如果集群资源已经耗尽,可以考虑添加新的节点。

2. 资源浪费

资源浪费通常表现为某些应用申请了过多的资源,而实际使用量却很低。为了解决这个问题,可以采取以下措施:

- 定期审查:定期检查各命名空间和应用的资源使用情况,及时调整配额。

- 自动化工具:利用自动化工具(如 Kubernetes 的 metrics-server 和 autoscaler)动态调整资源配额。

未来趋势:智能化资源管理

随着人工智能和机器学习技术的快速发展,Kubernetes 的资源管理也在向智能化方向发展。未来的资源配额管理可能会更加智能化,例如通过历史数据和机器学习模型自动预测资源需求,动态调整配额限制。此外,多集群管理平台的普及也将进一步提升资源管理的灵活性和效率。

总结

Kubernetes 的资源配额管理是集群管理中的核心任务之一。通过合理设置 CPU 和内存的请求与限制,结合命名空间级别的配额控制和实时监控工具,可以有效避免资源争用和浪费,提升集群的整体性能和稳定性。随着技术的不断进步,智能化的资源管理工具将进一步简化管理员的工作,帮助企业更好地应对复杂的资源管理挑战。

推荐阅读

-

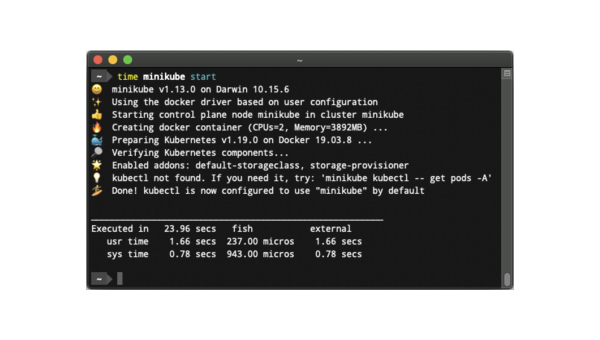

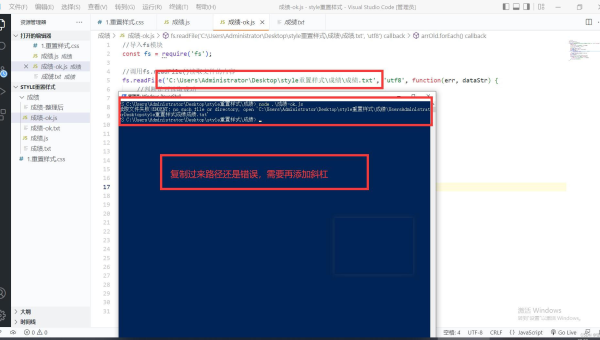

Linux怎么安装和使用Minikube搭建Kubernetes集群

-

Kubernetes 网络策略:Pod 间通信控制与安全隔离配置

-

Node.js 微服务部署:Kubernetes 自动扩缩容配置实战

-

Kubernetes 服务网格:Istio 与 Linkerd 的选型对比与实践

-

Kubernetes 存储类(StorageClass):动态卷供给与性能优化

-

Kubernetes 网络策略实战:基于标签的 Pod 间通信控制

-

Kubernetes 自定义资源定义(CRD):扩展集群功能的实战案例

-

Docker Swarm 集群管理:节点调度策略与服务发现机制解析

-

Kubernetes Horizontal Pod Autoscaler:CPU / 内存指标调优策略

-

Linux如何在命令行下创建和管理 Kubernetes 命名空间