为什么spark yarn 设置了spark.yarn.archive还是会重新上传

本篇内容介绍了“为什么spark yarn 设置了spark.yarn.archive还是会重新上传”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成!

[main] [INFO] [2021-04-13 15:32:59] Uploading resource hdfs://udp02:8020/user/zzm/spark-lib/arpack_combined_all-0.1.jar -> hdfs://cluster1/user/hadoop/.sparkStaging/application_1615460247184_26533/arpack_combined_all-0.1.jar

将

<property> <name>fs.defaultFS</name> <value>hdfs://ucluster1</value> </property>

改为:

<property> <name>fs.defaultFS</name> <value>hdfs://udp02:8020</value> </property>

“为什么spark yarn 设置了spark.yarn.archive还是会重新上传”的内容就介绍到这里了,感谢大家的阅读。如果想了解更多行业相关的知识可以关注恰卡编程网网站,小编将为大家输出更多高质量的实用文章!

推荐阅读

-

Notepad++ 插件推荐:代码折叠、语法高亮增强工具合集

-

Emacs Evil 模式:Vim 用户快速上手 Emacs 的过渡方案

-

Vim 寄存器深度解析:多缓冲区操作与复杂文本处理

-

Atom 主题切换:Material Design 与扁平化风格对比推荐

-

Lightly IDE 快捷键:Python 开发者必学的效率提升操作

-

Xcode 模拟器调试:多设备同步与性能监控技巧

-

PyCharm 代码格式化:黑魔法工具 Black 与自动规范配置

-

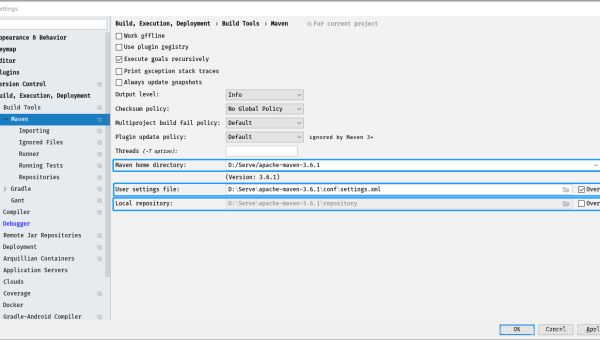

IntelliJ IDEA Docker 集成:微服务本地调试与镜像构建

-

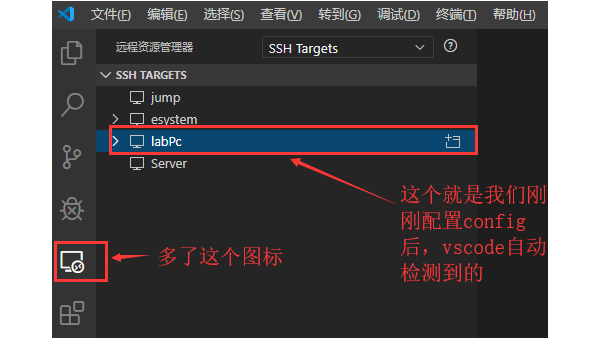

VS Code Remote SSH:远程服务器开发环境搭建全流程

-

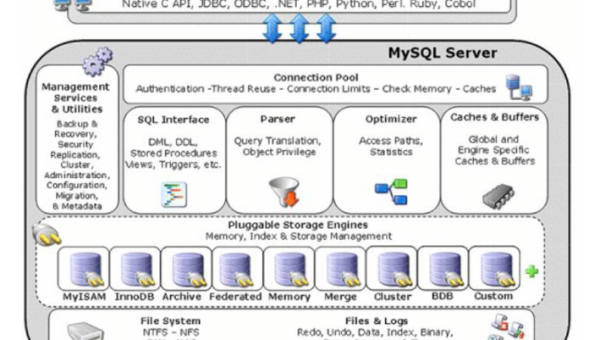

Retool 数据库连接:支持 MySQL、PostgreSQL 等多数据源配置