如何高效收集数据,方法与技巧详解

近期有些网友想要了解如何高效收集数据,方法与技巧详解的相关情况,小编通过整理给您分析,根据自身经验分享如何高效收集数据,方法与技巧详解有关知识。

如何高效且合规地收集数据

在信息驱动的时代,数据已成为决策的核心依据,无论是企业优化运营,还是个人提升效率,数据的收集与分析都扮演着关键角色,数据收集并非简单的“拿来主义”,它需要系统的方法、合规的流程以及对质量的严格把控,以下是关于如何科学收集数据的实用指南。

**第一步:明确目标与需求

数据收集的起点是清晰的目标,在开始前,需回答两个问题:

1、需要解决什么问题?

企业若想提升用户留存率,需明确收集用户行为数据还是反馈意见。

2、哪些数据能支持决策?

避免盲目收集冗余信息,聚焦关键指标,如用户点击率、页面停留时长等。

建议:制定数据需求清单,按优先级排序,确保后续步骤高效执行。

**第二步:选择可靠的数据来源

数据的质量直接依赖来源的可靠性,常见来源分为四类:

1、内部数据

企业自有数据库、CRM系统、销售记录等,这类数据通常结构化程度高,可直接调用。

2、公开数据

政府开放平台(如国家统计局)、行业报告、学术研究等,使用时需注意数据时效性和统计口径。

3、用户生成内容(UGC)

社交媒体评论、论坛讨论、产品评价等,这类数据需借助情感分析工具提取价值。

4、第三方合作

通过API接口或数据服务商获取,需签订协议,明确数据使用权限与隐私条款。

注意:优先选择官方或权威机构发布的数据,确保信息可信度。

**第三步:采用适配的收集方法

根据数据类型和目标,选择合适的技术手段:

1、主动收集:问卷与调研

- 设计问卷时,问题需简洁、无引导性,避免用户误解。

- 工具推荐:金数据、问卷星等平台支持逻辑跳转与数据分析。

2、被动收集:日志与传感器

- 网站埋点(如Google Analytics)可自动记录用户行为。

- 物联网设备通过传感器实时采集环境数据(如温度、湿度)。

3、自动化工具:爬虫与API

- 爬虫适用于公开网页信息抓取,但需遵守《反爬虫协议》和《个人信息保护法》。

- 商业API(如微博开放平台)提供结构化数据接口,适合规模化调用。

关键点:任何涉及个人隐私的数据必须获得用户明示同意。

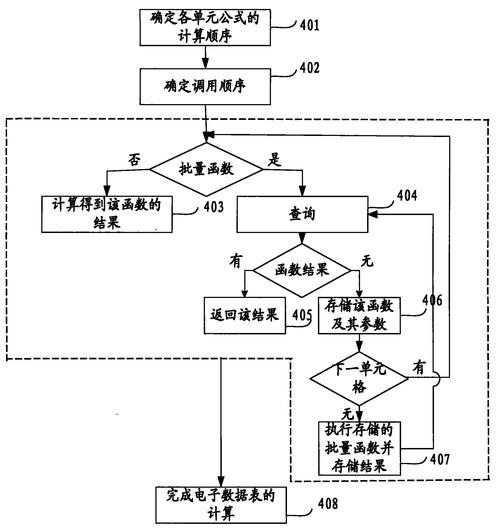

**第四步:数据清洗与验证

原始数据往往包含噪声,需通过以下步骤提纯:

1、去重与补全

删除重复记录,填补缺失值(如用平均值替代)。

2、异常值检测

通过统计模型(如3σ原则)识别异常数据,分析是否为录入错误或真实情况。

3、格式标准化

统一日期、货币单位等格式,便于后续分析。

案例:某电商平台发现部分订单地址缺失,通过用户历史数据补全,提升物流效率。

**第五步:合规与伦理的底线

数据收集必须在法律与道德框架内进行,重点关注:

1、遵守《个人信息保护法》

- 仅收集必要信息,明确告知用户用途。

- 未经授权不得共享或转售数据。

2、数据安全存储

- 敏感数据加密存储,定期备份。

- 使用阿里云、腾讯云等具备安全认证的平台。

3、避免算法偏见

- 抽样时需覆盖多样本群体,防止结论片面化。

**个人观点

数据收集不是一次性任务,而是动态优化的过程,随着技术发展,工具和方法会迭代,但核心逻辑不变:以目标为导向,以合规为前提,以质量为生命线,建议从业者定期复盘数据策略,关注行业新规(如生成式AI数据使用规范),保持对风险的敏感度,数据的价值不在于“多”,而在于“准”——精准的数据才能转化为有效的行动力。