如何在CentOS系统中正确安装与配置HBA卡?

HBA卡在CentOS环境中的作用与配置

在服务器硬件配置中,HBA卡(Host Bus Adapter)是一个关键组件,尤其在需要连接外部存储设备(如SAN、NAS)的场景中,对于运行CentOS系统的服务器而言,正确选择和配置HBA卡不仅能提升存储性能,还能确保数据的高可靠性,本文将从实际应用角度出发,解析HBA卡的功能、配置方法及常见问题解决方案。

一、HBA卡的基础认知

HBA卡是服务器与存储设备之间的桥梁,负责将主机的数据传输到存储网络,与普通网卡不同,HBA卡专为存储协议(如Fibre Channel、SAS、iSCSI)设计,支持更高的带宽和更低的延迟,Fibre Channel HBA卡常用于企业级SAN环境,而SAS HBA卡则适合直连存储设备。

在CentOS系统中,HBA卡的性能直接影响存储I/O效率,若服务器需要处理大量并发请求(如数据库服务或虚拟化平台),选择支持多队列、高吞吐量的HBA卡尤为重要。

二、CentOS下HBA卡的识别与驱动管理

1、硬件识别

安装HBA卡后,首先需确认系统是否识别到设备,通过命令lspci | grep -i "fibre\|sas"可查看已连接的HBA卡信息,若未显示,需检查硬件连接或PCI插槽兼容性。

2、驱动安装与更新

CentOS默认支持主流HBA卡驱动(如QLogic、Broadcom),但部分新型号可能需要手动安装。

- 通过dmesg | grep hba查看内核日志中的驱动加载状态。

- 若驱动未自动加载,需从厂商官网下载对应驱动包,按文档编译安装。

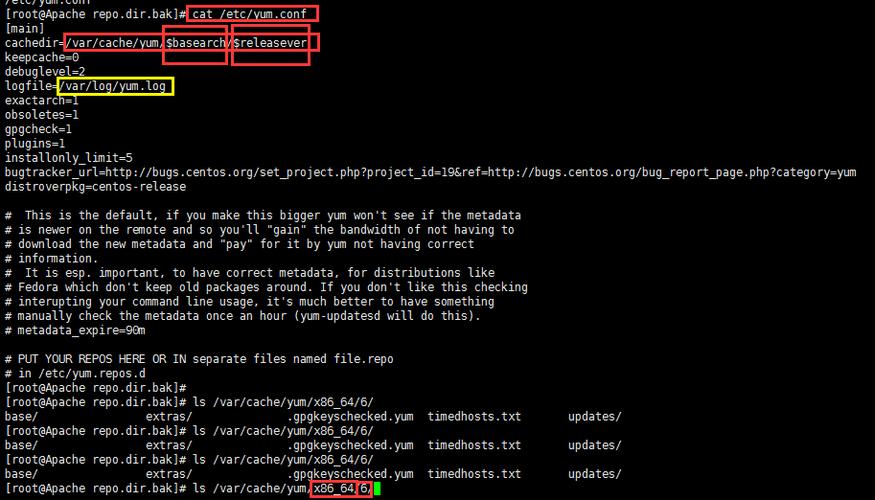

- 定期更新驱动可修复已知问题并提升性能,建议通过yum update或厂商提供的更新工具操作。

3、多路径配置(Multipath)

为提高存储链路冗余性,通常需要配置多路径,CentOS内置device-mapper-multipath工具,通过编辑/etc/multipath.conf文件定义路径策略,结合multipath -ll命令验证配置是否生效。

三、HBA卡性能优化实践

1、队列深度调整

HBA卡的队列深度(Queue Depth)决定了同时处理的I/O请求数量,过低的队列深度会导致性能瓶颈,可通过调节内核参数优化:

echo "1024" > /sys/block/sdX/device/queue_depth

需根据实际负载测试确定最佳值,避免过度占用系统资源。

2、中断亲和性设置

在NUMA架构服务器中,将HBA卡的中断绑定到特定CPU核心可减少跨节点访问延迟,使用irqbalance工具或手动修改/proc/irq/[IRQ编号]/smp_affinity文件实现。

3、固件与驱动版本匹配

HBA卡的固件版本需与驱动程序兼容,厂商通常提供配套的固件升级工具,建议在业务低峰期进行操作,并提前备份数据。

四、常见问题排查指南

场景1:系统无法识别HBA卡

- 检查PCI插槽供电是否正常。

- 确认HBA卡型号是否被CentOS内核支持,或尝试升级内核版本。

场景2:存储性能突然下降

- 使用iostat -x 1监控I/O等待时间,确认是否为HBA卡瓶颈。

- 检查光纤链路是否存在松动或光模块故障。

场景3:多路径切换失败

- 验证multipath.conf中的路径优先级配置。

- 使用scsi_id命令确认存储LUN的唯一标识是否正确。

五、HBA卡选型与运维建议

1、选型优先级

协议匹配:根据存储网络类型选择FC、SAS或iSCSI HBA卡。

带宽需求:25Gb/s或更高带宽的HBA卡更适合高吞吐场景。

厂商支持:优先选择提供长期驱动更新的品牌(如Broadcom、ATTO)。

2、运维注意事项

- 定期监控HBA卡的温度和错误计数器,防止硬件老化导致故障。

- 在虚拟化环境中,为HBA卡启用SR-IOV功能可提升虚拟机存储性能。

- 避免混合使用不同厂商的HBA卡,以减少兼容性问题。

无论是构建企业级存储架构,还是优化现有服务器性能,HBA卡的正确配置与管理都是不可忽视的环节,对于CentOS用户而言,深入理解硬件与操作系统的协同机制,结合实际业务需求调整参数,才能最大化发挥存储系统的潜力。