如何在Excel中快速去重并删除重复数据?

近期有些网友想要了解如何在Excel中快速去重并删除重复数据的相关情况,小编通过整理给您分析,根据自身经验分享有关知识。

Excel作为数据处理的核心工具之一,在日常办公中承担着大量数据清洗任务,数据去重是高频需求,但许多用户仅停留在基础操作层面,本文将深入解析Excel去重的多维解决方案,帮助用户根据具体场景选择最优策略。

基础去重方案

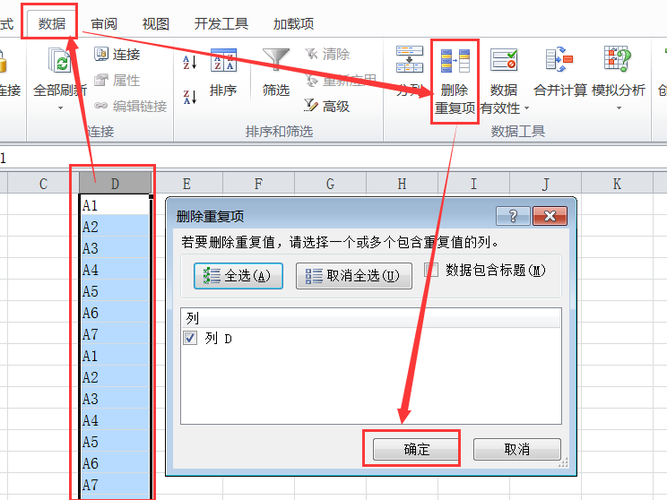

1、内置功能(推荐新手)

定位至数据区域任意单元格 → 选择「数据」选项卡 → 单击「删除重复项」按钮 → 勾选需要核对的字段 → 确认后系统自动删除重复记录,此方法会直接修改原数据,建议操作前创建副本,注意:Excel将保留首次出现的数据记录,后续重复项整体删除。

2、条件格式标记法

选中目标列 → 进入「开始」选项卡 → 打开条件格式 → 选择「突出显示单元格规则」→ 点击「重复值」→ 设定高亮颜色,此方法不删除数据,适用于需要人工复核的场景,标记后的重复项可通过筛选功能批量处理。

进阶处理方法

3、函数组合方案

*UNIQUE函数(Office 365专属)*:在空白单元格输入=UNIQUE(A2:A100)即可生成去重列表,动态数组特性支持自动扩展。

*经典公式法*:在B2输入=IF(COUNTIF(A$2:A2,A2)=1,A2,"")并下拉填充,配合筛选功能提取非空值,此方法适用于所有Excel版本,建议搭配辅助列使用。

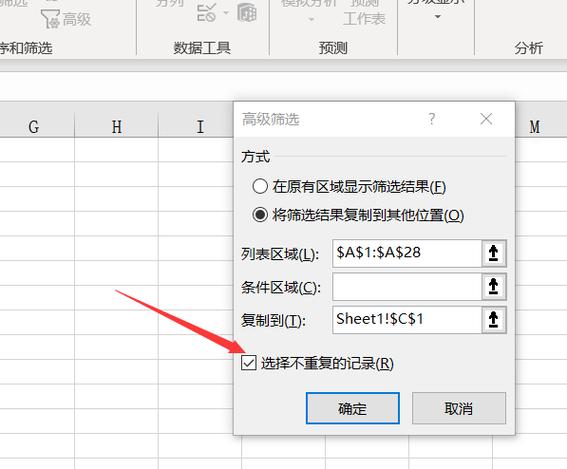

4、高级筛选应用

点击「数据」→「高级筛选」→ 选择「将筛选结果复制到其他位置」→ 指定「列表区域」和「复制到」区域 → 勾选「选择不重复的记录」,此方法可生成独立去重列表,保留原始数据完整性。

工程级解决方案

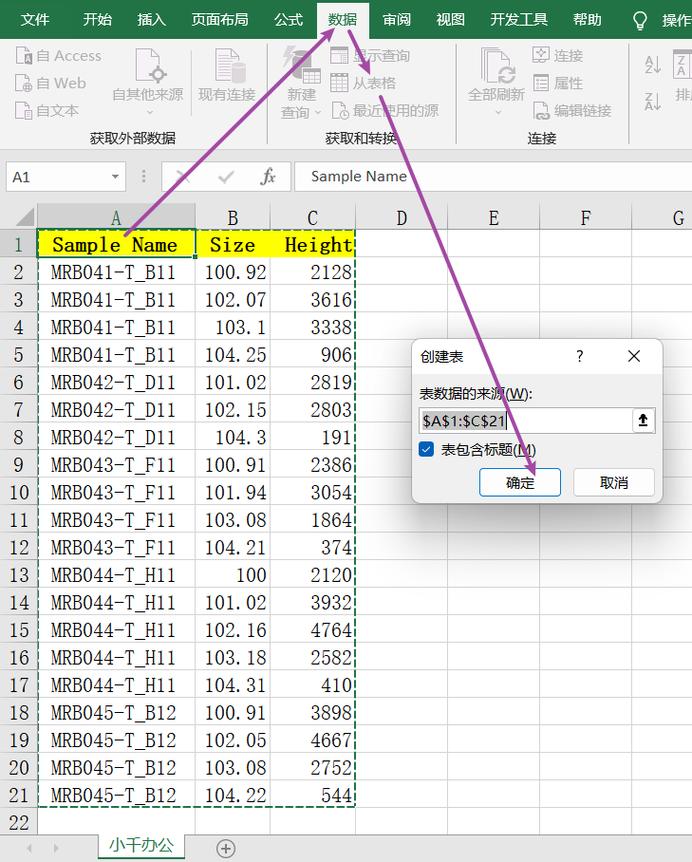

5、Power Query处理

选中数据区域 → 点击「数据」→「从表格/区域」→ 在Power Query编辑器选择目标列 → 右键选择「删除重复项」→ 关闭并上载至新工作表,此工具支持百万级数据处理,且操作可逆,特别适合定期更新的数据集。

6、VBA脚本开发

按Alt+F11打开VBA编辑器 → 插入新模块 → 输入以下代码:

Sub RemoveDuplicates() With ActiveSheet .Range("A1:C100").RemoveDuplicates Columns:=Array(1,2), Header:=xlYes End With End Sub修改Range参数指定数据范围,Array参数设定校验字段,此方案适合需要定制化去重规则的技术用户。

特殊场景处理技巧

多列联合去重:在删除重复项对话框勾选多个字段,Excel将校验所有选定字段的组合唯一性,注意字段顺序不影响判断逻辑。

区分大小写处理:默认不区分大小写,需使用公式=EXACT(A2,UPPER(A2))创建辅助列配合筛选。

跨工作表去重:建议使用公式=COUNTIF(Sheet2!A:A,A2)=0建立校验列,结合筛选实现跨表查重。

操作避坑指南

1、执行删除操作前务必确认数据备份,建议使用「另存为」创建副本文件

2、合并单元格会导致去重功能失效,需提前取消单元格合并

3、包含公式的单元格可能因计算设置导致误判,建议转换为数值后再处理

4、文本型数字与数值型数字会被视为不同数据,需统一格式

实际工作中,建议根据数据规模选择工具:万级以下数据推荐内置功能,十万级使用Power Query,更大数据量建议先进行分批次处理,对于需要持续维护的数据集,建立标准的预处理流程比单次操作更重要,个人更倾向于使用Power Query方案,其可视化界面与可追溯特性既能保证处理效率,又方便后续审计复核。