如何在 Linux命令行下对文本进行词频统计

作者

近期有些网友想要了解的相关情况,小编通过整理给您分享一下。

在日常的文本处理任务中,词频统计是一项常见且重要的操作。无论是分析日志文件、处理文本数据,还是进行自然语言处理,掌握在 Linux 命令行下进行词频统计的技巧都能极大提高工作效率。本文将详细介绍几种实用的方法,帮助你在命令行中轻松完成词频统计。

使用 tr 和 sort 命令

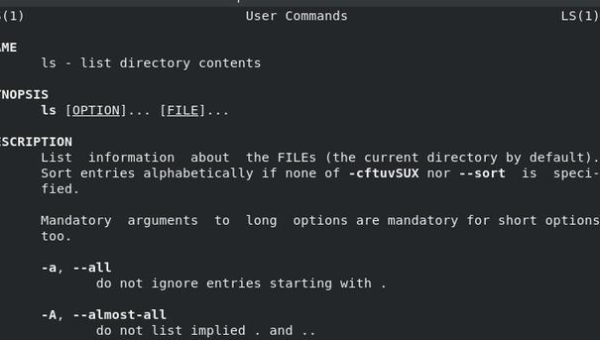

tr 命令用于转换或删除字符,而 sort 命令则可以对文本进行排序。结合这两个命令,我们可以对文本进行初步处理,为后续的词频统计打下基础。

cat file.txt | tr '[:space:]' '\n' | tr -d '[:punct:]' | sort | uniq -c | sort -nr步骤解析

cat file.txt:读取文件内容。tr '[:space:]' '\n':将空格、制表符等空白字符转换为换行符,使每个单词占据一行。tr -d '[:punct:]':删除标点符号,确保统计的准确性。sort:对单词进行排序,便于uniq命令处理。uniq -c:统计每个单词的出现次数。sort -nr:按出现次数从高到低排序。

使用 awk 命令

awk 是一种强大的文本处理工具,能够以更灵活的方式处理文本数据。通过 awk,我们可以直接进行词频统计。

awk '{for(i=1;i<=NF;i++) words[$i]++} END {for(word in words) print words[word], word}' file.txt | sort -nr步骤解析

for(i=1;i<=NF;i++) words[$i]++:遍历每一行的每个单词,并将其存储在关联数组words中,同时统计出现次数。END {for(word in words) print words[word], word}:在处理完所有行后,输出每个单词及其出现次数。sort -nr:按出现次数从高到低排序。

使用 grep 和 wc 命令

如果你只需要统计特定单词的出现次数,grep 和 wc 命令可以快速完成这一任务。

grep -o 'word' file.txt | wc -l步骤解析

grep -o 'word' file.txt:精确匹配并输出所有word单词。wc -l:统计输出的行数,即word的出现次数。

使用 python 脚本

对于更复杂的词频统计需求,可以使用 python 脚本进行处理。python 提供了丰富的文本处理库,能够轻松应对各种统计任务。

from collections import Counterimport rewith open('file.txt', 'r') as file: words = re.findall(r'\b\w+\b', file.read().lower()) word_counts = Counter(words) for word, count in word_counts.most_common(): print(f"{count}: {word}")步骤解析

re.findall(r'\b\w+\b', file.read().lower()):使用正则表达式匹配所有单词,并将其转换为小写。Counter(words):统计每个单词的出现次数。most_common():按出现次数从高到低排序并输出。

总结

在 Linux 命令行下进行词频统计有多种方法,每种方法都有其独特的优势。tr 和 sort 命令适合简单的统计任务,awk 命令提供了更高的灵活性,grep 和 wc 命令则适合快速统计特定单词的出现次数,而 python 脚本则能应对更复杂的统计需求。掌握这些方法,你将能够高效处理各种文本数据,提升工作效率。

通过本文的介绍,相信你已经对如何在 Linux 命令行下进行词频统计有了全面的了解。无论你是初学者还是经验丰富的开发者,这些技巧都将为你的文本处理任务带来极大的便利。

目录