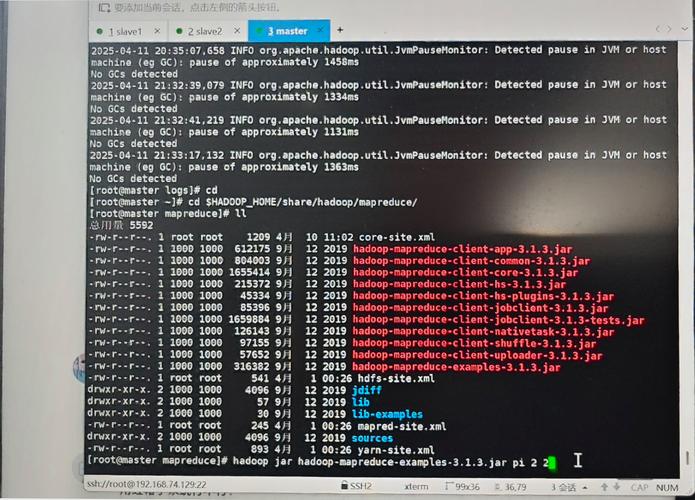

Hadoop jar 运行报错,如何解决?

在处理大数据任务时,许多开发者和运维人员会选择使用 Hadoop 来运行 Jar 包以执行分布式计算任务,在实际操作过程中,运行 hadoop jar 命令时可能会遇到各种报错,这些问题往往令人困扰,本文将针对常见的报错类型进行分析,并提供相应的解决方案,帮助您更高效地定位和解决问题。

常见报错类型及原因分析

-

ClassNotFoundException 或 NoClassDefFoundError

这类错误通常是由于缺少依赖库或类路径配置不正确导致的,Hadoop 运行时无法找到所需的类文件,可能的原因包括:- Jar 包未包含所有依赖项;

- Hadoop 集群环境中未正确设置

HADOOP_CLASSPATH; - 用户代码中引用了未打包的第三方库。

-

权限不足错误

例如出现Permission denied或AccessControlException,这通常与 Hadoop 的用户权限管理有关,Hadoop 集群可能启用了安全模式(如 Kerberos 认证),或者用户对 HDFS 中的路径没有读写权限。 -

资源分配问题

如果任务无法启动或中途失败,可能是由于资源不足导致的。- 内存分配不足(Container 内存超限);

- CPU 或磁盘资源紧张;

- YARN 资源队列配置不合理。

-

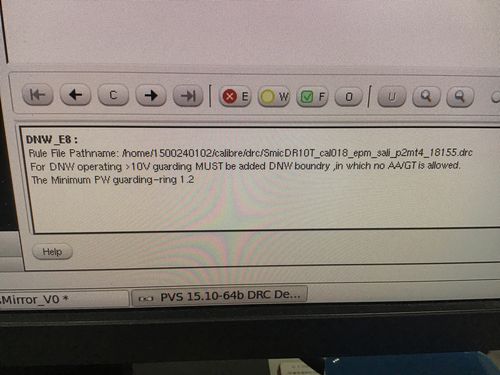

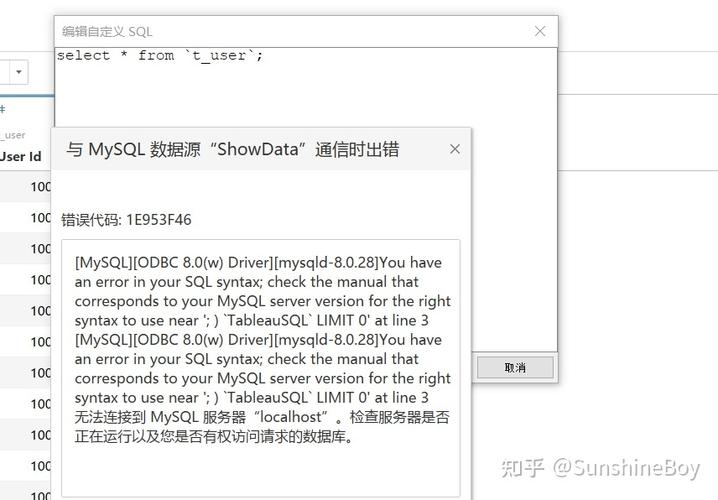

网络或通信错误

Connection refused或Timeout exception,这类问题通常是由于集群节点之间的网络通信异常造成的,可能的原因包括:- 防火墙阻止了端口通信;

- Hadoop 服务未正常启动;

- 主机名或 IP 配置错误。

解决方案与排查方法

-

依赖库问题处理

建议使用 Maven 或 Gradle 构建工具,并通过maven-assembly-plugin或maven-shade-plugin生成包含所有依赖的 Uber Jar,可以通过以下命令手动添加类路径:export HADOOP_CLASSPATH=/path/to/your/jar:$HADOOP_CLASSPATH -

权限问题调整

如果是 HDFS 权限问题,可以通过以下命令修改目录权限:hdfs dfs -chmod -R 755 /user/yourdir若集群启用了 Kerberos 认证,请确保已使用

kinit命令获取有效票据。 -

资源分配优化

在提交任务时,可以通过以下参数调整资源分配:hadoop jar your.jar -Dmapreduce.map.memory.mb=2048 -Dmapreduce.reduce.memory.mb=4098同时检查

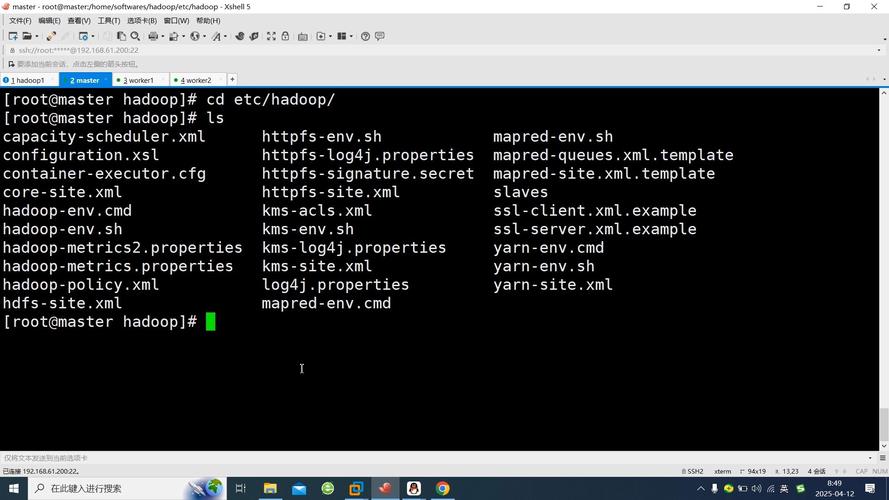

yarn-site.xml中的资源调度配置,确保队列资源分配合理。 -

网络问题排查

确认所有节点的 Hadoop 服务(如 NameNode、DataNode、ResourceManager)均处于正常运行状态,使用telnet或ping检查节点间通信是否畅通,并检查/etc/hosts和防火墙设置。

调试与日志分析技巧

当报错信息不够明确时,可以通过以下方式进一步排查:

- 在提交命令中添加

-Dmapreduce.job.verbose=true参数启用详细日志; - 查看 YARN 的应用程序日志:

yarn logs -applicationId - 检查 Hadoop 服务日志(如 NameNode、DataNode 日志),通常位于

/var/log/hadoop/目录下。

作为长期使用 Hadoop 的开发者,我认为处理这类报错的关键在于耐心和系统性排查,许多问题看似复杂,但通过逐步分析日志、调整配置和优化资源分配,通常能够找到解决方案,建议在测试环境中充分验证任务后再部署到生产集群,以减少运行时异常的发生。