python中Scikit-Learn怎么用

python中Scikit-Learn怎么用

这篇文章主要介绍python中Scikit-Learn怎么用,文中介绍的非常详细,具有一定的参考价值,感兴趣的小伙伴们一定要看完!

1、数据集

学习算法时,我们都希望有一些数据集可以练手。Scikit learn 附带一些非常棒的数据集,如iris数据集、房价数据集、糖尿病数据集等。

这些数据集非常容易获取、同时也易于理解,你可以直接在其上实现ML模型,非常适合初学者。

你可以按如下方式即可获取:

importsklearnfromsklearnimportdatasetsimportpandasaspddataset=datasets.load_iris()df=pd.DataFrame(dataset.data,columns=dataset.feature_names)

同样,你可以用同样的方式导入其他数据集。

2、数据拆分

Sklearn 提供了拆分数据集以进行训练和测试的功能。拆分数据集对于预测性能的无偏见评估至关重要,可以定义训练和测试数据集中的数据比例。

我们可以按如下方式拆分数据集:

fromsklearn.model_selectionimporttrain_test_splitx_train,x_test,y_train,y_test=train_test_split(x,y,test_size=2,random_state=4)

在train_test_split 的帮助下,我们对数据集进行了拆分,使得训练集有 80% 的数据和测试集有 20% 的数据。

3、线性回归

当输出变量为连续变量且与因变量呈线性关系时,使用监督机器学习模型,它可以通过分析前几个月的销售数据来预测未来几个月的销售。

借助sklearn,我们可以轻松实现线性回归模型,如下所示:

fromsklearn.linear_modelimportLinearRegressionfromsklearn.metricsimportmean_squared_error,r2_scoreregression_model=LinearRegression()regression_model.fit(x_train,y_train)y_predicted=regression_model.predict(x_test)rmse=mean_squared_error(y_test,y_predicted)r2=r2_score(y_test,y_predicted)

首先LinerRegression()创建一个线性回归的对象,然后我们在训练集上拟合模型。最后,我们在测试数据集上预测了模型。 "rmse"和"r_score"可用于检查模型的准确性。

4、逻辑回归

逻辑回归也是一种监督回归算法,就像线性回归一样。唯一的区别是输出变量是分类的。它可用于预测患者是否患有心脏病。

借助 sklearn,我们可以轻松实现 Logistic 回归模型,如下所示:

fromsklearn.linear_modelimportLogisticRegressionfromsklearn.metricsimportconfusion_matrixfromsklearn.metricsimportclassification_reportlogreg=LogisticRegression()logreg.fit(x_train,y_train)y_predicted=logreg.predict(x_test)confusion_matrix=confusion_matrix(y_test,y_pred)print(confusion_matrix)print(classification_report(y_test,y_pred))

混淆矩阵和分类报告用于检查分类模型的准确性。

5、决策树

决策树是一个强大的工具,可用于分类和回归问题。它由根和节点组成,根代表分裂的决定,节点代表输出变量值。当因变量与自变量不遵循线性关系时,决策树很有用。

用于分类的决策树实现:

fromsklearn.treeimportDecisionTreeClassifierfromsklearn.metricsimportconfusion_matrixfromsklearn.treeimportexport_graphvizfromsklearn.externals.siximportStringIOfromIPython.displayimportImagefrompydotimportgraph_from_dot_datadt=DecisionTreeClassifier()dt.fit(x_train,y_train)dot_data=StringIO()export_graphviz(dt,out_file=dot_data,feature_names=iris.feature_names)(graph,)=graph_from_dot_data(dot_data.getvalue())y_pred=dt.predict(x_test)

我们使用 DecisionTreeClassifier() 对象拟合模型,并使用进一步的代码来可视化 Python 中的决策树实现。

6、Bagging

Bagging是一种使用训练集中的随机样本训练相同类型的多个模型的技术。不同模型的输入是相互独立的。

对于前一种情况,可以使用多个决策树进行预测,而不仅仅是一个被称为随机森林的决策树。

7、Boosting

Boosting 多个模型的训练方式是,一个模型的输入取决于前一个模型的输出。在 Boosting 中,对预测错误的数据给予更多的优先权。

8、随机森林

随机森林是一种 bagging 技术,它使用成百上千的决策树来构建模型,用于分类和回归问题。比如:贷款申请人分类、识别欺诈活动和预测疾病。

在 python 中实现如下:

fromsklearn.ensembleimportRandomForestClassifiernum_trees=100max_features=3clf=RandomForestClassifier(n_estimators=num_trees,max_features=max_features)clf.fit(x_train,y_train)y_pred=clf.predict(x_test)print("Accuracy:",metrics.accuracy_score(y_test,y_pred))

9、XGBoost

XGBoost 是一种提升技术,可提供梯度提升决策树的高性能实现。它可以自行处理丢失的数据,支持正则化并且通常比其他模型给出更准确的结果。

在 python 中实现如下:

fromxgboostimportXGBClassifierfromsklearn.metricsimportmean_squared_errorxgb=XGBClassifier(colsample_bytree=0.3,learning_rate=0.1,max_depth=5,alpha=10,n_estimators=10)xgb.fit(x_train,y_train)y_pred=xgb.predict(x_test)rmse=np.sqrt(mean_squared_error(y_test,preds))print("RMSE:%f"%(rmse))

10、支持向量机(SVM)

SVM是一种监督机器学习算法,通过找到最好的超平面来进行分类,它通常被用于许多应用程序,例如人脸检测、邮件分类等。

在 python 中实现为:

fromsklearnimportsvmfromsklearnimportmetricsclf=svm.SVC(kernel='linear')clf.fit(X_train,y_train)y_pred=clf.predict(X_test)print("Accuracy:",metrics.accuracy_score(y_test,y_pred))

11、混淆矩阵

混淆矩阵是用于描述分类模型性能的表格。混淆矩阵以如下4项的帮助下进行分析:

真阳性(TF)

这意味着模型预测为正,实际上为正。

真阴性(TN)

这意味着模型预测为负,实际上为负。

误报(FP)

这意味着模型预测为正,但实际上为负。

假阴性(FN)

这意味着模型预测为负,但实际上为正。

Python 可以实现

fromsklearn.metricsimportconfusion_matrixconfusion_matrix=confusion_matrix(y_test,y_pred)print(confusion_matrix)

12、K-均值聚类

K-Means 聚类是一种用于解决分类问题的无监督机器学习算法。无监督算法是数据集中没有标签或输出变量的算法。

在聚类中,数据集根据特征分成不同的组,称为集群。k-means 聚类有很多应用,例如市场分割、文档聚类、图像分割。

它可以在python中实现为:

fromsklearn.clusterimportKMeansimportstatsmodels.apiassmkmeans=KMeans(3)means.fit(x)identified_clusters=kmeans.fit_predict(x)

13、DBSCAN 聚类

DBSCAN 也是一种无监督聚类算法,它根据数据点之间的相似性进行聚类。 在 DBSCAN 中,只有当指定半径的簇中的点数最少时,才会形成簇。

DBSCAN 的优势在于它对异常值具有鲁棒性,即它可以自行处理异常值,这与 k 均值聚类不同。DBSCAN 算法用于创建热图、地理空间分析、温度数据中的异常检测。

它可以实现为:

fromsklearn.clusterimportDBSCANfromsklearnimportmetricsfromsklearn.preprocessingimportStandardScalerdb=DBSCAN(eps=0.3,min_samples=10).fit(X)core_samples_mask=np.zeros_like(db.labels_,dtype=bool)core_samples_mask[db.core_sample_indices_]=Truelabels=db.labels_n_clusters_=len(set(labels))-(1if-1inlabelselse0)print(labels)

14、标准化和规范化

标准化

标准化是一种缩放技术,我们将属性的均值设为 0,将标准差设为 1,从而使值以具有单位标准差的均值为中心。 它可以做为 X’= (X-μ)/σ

正常化

归一化是一种使值的范围从 0 到 1 的技术,它也称为最小-最大缩放。 归一化可以通过给定的公式 X= (X -Xmin)/(Xmax-Xmin) 来完成。

fromsklearn.preprocessingimportStandardScalerfromsklearn.preprocessingimportMinMaxScaler

Python 提供了 StandardScaler 函数用于实现标准化,MinMaxScaler 函数用于规范化。

15、特征提取

特征提取是从数据中提取特征的方法。如果将数据转换为数字格式,我们只能将数据传递给机器学习模型。Scikit-Learn 提供了将文本和图像转换为数字的功能。

Bag of Words 和 TF-IDF 是 scikit-learn 提供的自然语言处理中最常用的将单词转换为数字的方法。

以上是“python中Scikit-Learn怎么用”这篇文章的所有内容,感谢各位的阅读!希望分享的内容对大家有帮助,更多相关知识,欢迎关注恰卡编程网行业资讯频道!

推荐阅读

-

Python 3.12 新特性解析:模式匹配增强与性能优化实战

-

Lightly IDE 深度评测:轻量级 Python 开发工具是否适合团队协作?

-

VS Code 自定义配置:JSON 文件修改、代码片段与任务自动化脚本

-

Python 虚拟环境选择:venv、conda、poetry 的适用场景对比

-

PyCharm+GitHub Copilot:Python 开发中 AI 辅助编码的最佳实践

-

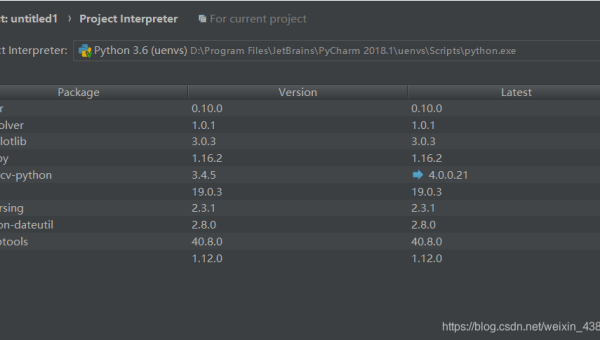

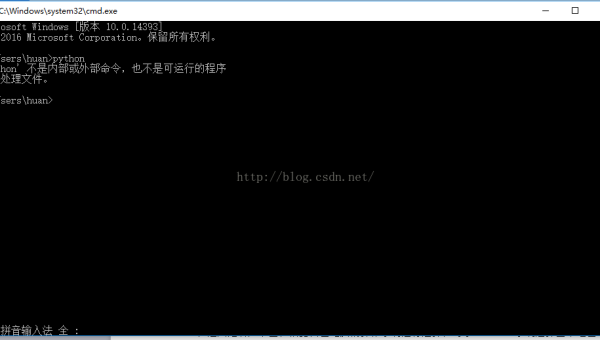

PyCharm 无法识别虚拟环境?5 步排查 Python 解释器配置问题

-

数据科学工具链:Jupyter Notebook+RStudio+Python 的协同工作流

-

Python 3.12 新特性:模式匹配增强与性能改进实战

-

Lightly IDE 适合谁?轻量级 Python 开发工具深度评测

-

Python IDE 终极对比:PyCharm vs VS Code vs Jupyter Notebook