GitHub Copilot 伦理争议:AI 代码生成中的版权与代码安全问题

引言

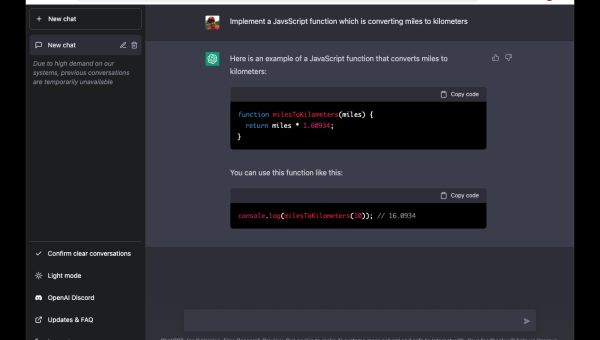

GitHub Copilot 的推出引发了广泛关注,它是一款由 AI 驱动的代码生成工具,能够帮助开发者快速编写代码。然而,随着其广泛应用,关于版权归属和代码安全的伦理争议也随之浮现。本文将从这两个角度深入探讨 GitHub Copilot 带来的挑战。

版权归属的困惑

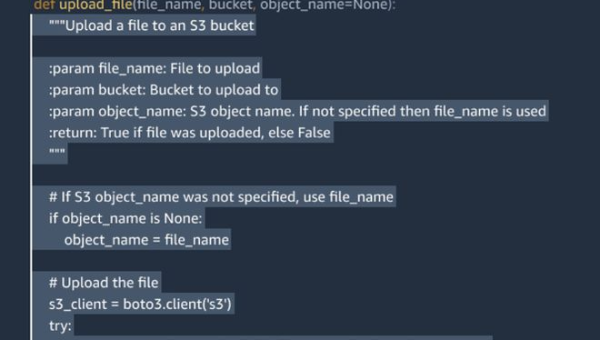

AI 生成代码的版权归属问题是一个亟待解决的难题。GitHub Copilot 在编写代码时,会参考大量的开源代码和文档,这使得生成的代码可能包含他人的智力成果。那么,这些代码的版权应该归属于谁?是开发者,还是 GitHub Copilot 的运营方?

开源社区对此反应强烈。许多开发者担心,AI 生成的代码可能会无意中侵犯开源协议的规定。例如,某些开源项目要求用户在分发代码时必须公开源代码,而 AI 生成的代码是否需要遵守这一规定尚不明确。

此外,AI 生成代码的原创性也引发了争议。如果一段代码是由 AI 自动生成的,那么它是否具有原创性?这不仅关系到版权归属,还可能影响软件行业的创新激励机制。

代码安全的隐忧

GitHub Copilot 的代码生成能力虽然强大,但也带来了潜在的安全风险。AI 在生成代码时,可能会引入隐藏的漏洞或后门。这些漏洞可能被恶意利用,导致严重的安全问题。

更令人担忧的是,AI 生成的代码可能难以被人工审查。由于代码量庞大且复杂,开发者可能无法及时发现隐藏的漏洞。这使得依赖 AI 生成代码的项目面临更大的安全风险。

为了应对这一挑战,开发者需要采取额外的措施来确保代码的安全性。例如,可以引入代码审查工具,或者加强对 AI 生成代码的测试和验证。

未来的展望

面对这些伦理争议,GitHub Copilot 的开发者和用户都需要采取积极的态度。一方面,GitHub 应该加强对代码生成过程的透明度,明确版权归属规则;另一方面,开发者也应该提高对 AI 生成代码的审查意识,确保代码的安全性。

在技术与伦理的平衡上,我们需要更多的讨论和探索。只有在确保技术安全和尊重知识产权的前提下,GitHub Copilot 才能真正成为开发者的好帮手。

结语

GitHub Copilot 的出现标志着 AI 在软件开发领域的广泛应用,但也带来了版权和安全方面的挑战。解决这些问题需要多方的共同努力,只有在技术与伦理的平衡中,才能实现可持续的发展。

推荐阅读

-

AI 编程工具发展现状:GitHub Copilot 引发的代码生成范式变革

-

AI 辅助编程工具评测:如何利用 Copilot 提升代码质量与开发效率?

-

VS Code 2025 重大更新:AI 代码补全增强与远程开发体验升级

-

GitHub Copilot 代码生成:如何避免 AI 生成代码的安全隐患?

-

医疗人工智能技术是如何改善生活(人工智能、大数据如何服务医疗器械创新)

人工智能、大数据如何服务医疗器械创新?自动驾驶首先进入服务业,它的创新能力远超人类的想象人工智能后,人类该如何生存?大颠覆时代到来...

-

华人如何改变人工智能?以史为鉴能让我们更好地去伪存真

华人如何改变人工智能?以史为鉴能让我们更好地去伪存真,恰卡网带你了解更多相关信息。自1998年成立以来,微软亚研为中国...

-

准确率90%的AI机器人,是省事,还是添乱?

准确率90%的AI机器人,是省事,还是添乱?说到机器人和自动化,很多人脑里可能会立刻浮现一些生产线,比如汽车工厂的情景——一群机器...

-

如何实现人工智能AI猜你画的是什么

这篇文章主要介绍了如何实现人工智能AI猜你画的是什么,具有一定借鉴价值,感兴趣的朋友可以参考下,希望大家阅读完这篇文章之后大有收获...

-

关于人工智能不正确的说法是什么

这篇文章主要介绍了关于人工智能不正确的说法是什么,具有一定借鉴价值,感兴趣的朋友可以参考下,希望大家阅读完这篇文章之后大有收获,下...