python中scrapy重复执行的实现方法

这篇文章给大家分享的是有关python中scrapy重复执行的实现方法的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,我们只需要实现少量的代码,就能够快速的抓取

Scrapy模块:

1、scheduler:用来存放url队列

2、downloader:发送请求

3、spiders:提取数据和url

4、itemPipeline:数据保存

fromtwisted.internetimportreactor,defer

fromscrapy.crawlerimportCrawlerRunner

fromscrapy.utils.logimportconfigure_logging

importtime

importlogging

fromscrapy.utils.projectimportget_project_settings

#在控制台打印日志

configure_logging()

#CrawlerRunner获取settings.py里的设置信息

runner=CrawlerRunner(get_project_settings())

@defer.inlineCallbacks

defcrawl():

whileTrue:

logging.info("newcyclestarting")

yieldrunner.crawl("xxxxx")

#1s跑一次

time.sleep(1)

reactor.stop()

crawl()

reactor.run()感谢各位的阅读!关于“python中scrapy重复执行的实现方法”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,让大家可以学到更多知识,如果觉得文章不错,可以把它分享出去让更多的人看到吧!

推荐阅读

-

一文教你Python如何快速精准抓取网页数据

本文将使用requests和beautifulsoup这两个流行的库来实现。1.准备工作首先安装必要的库:pipinst...

-

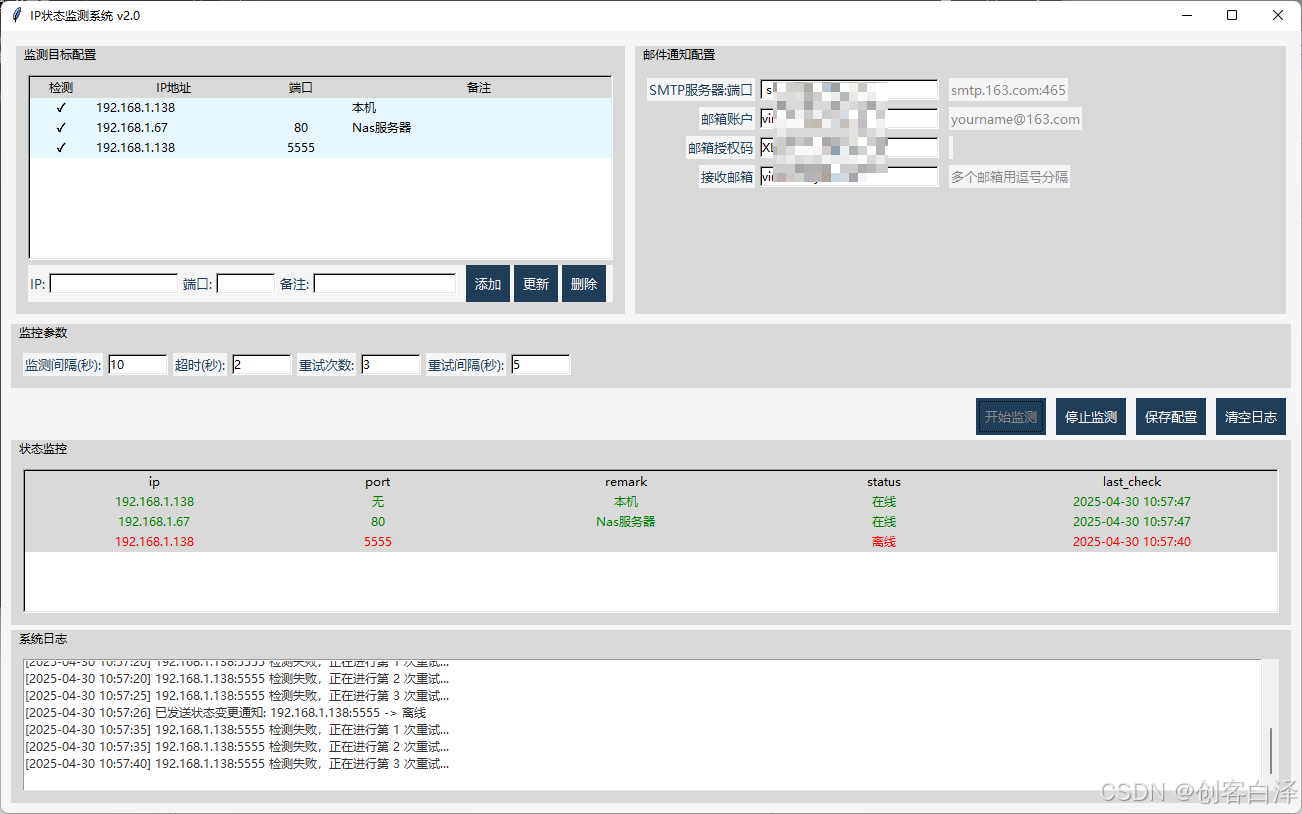

使用Python实现IP地址和端口状态检测与监控

-

基于Python打造一个智能单词管理神器

-

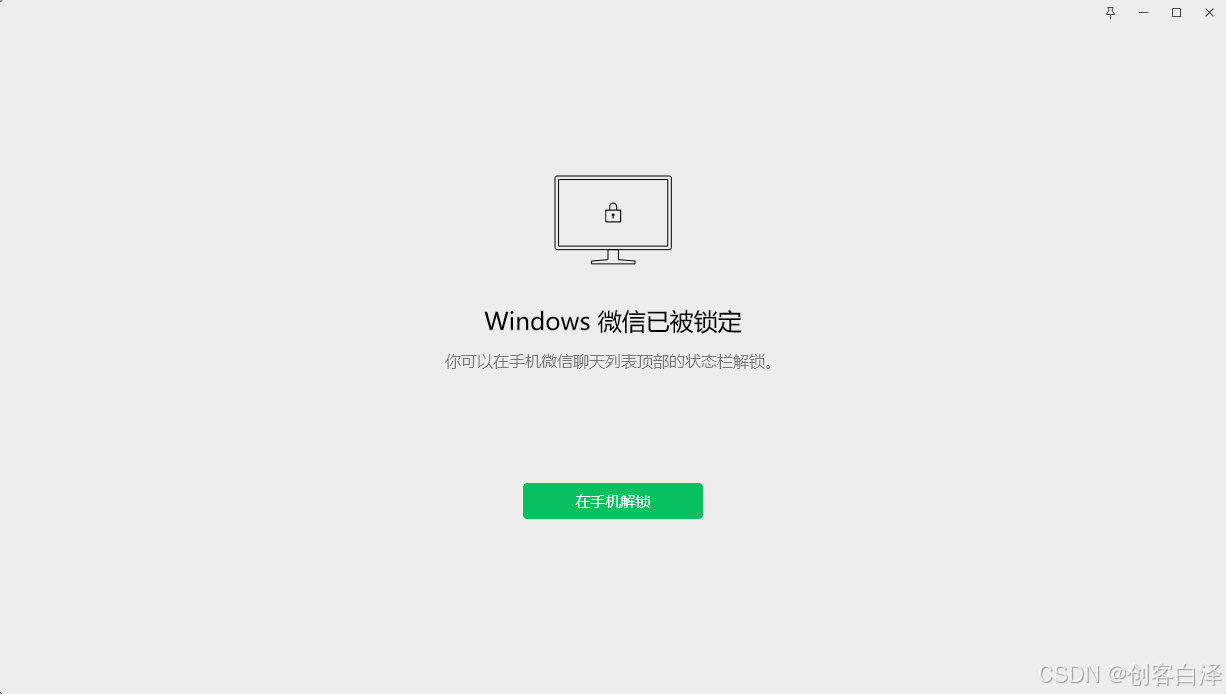

Python实现微信自动锁定工具

-

使用Python创建一个功能完整的Windows风格计算器程序

python实现windows系统计算器程序(含高级功能)下面我将介绍如何使用python创建一个功能完整的windows风格计...

-

Python开发文字版随机事件游戏的项目实例

随机事件游戏是一种通过生成不可预测的事件来增强游戏体验的类型。在这类游戏中,玩家必须应对随机发生的情况,这些情况可能会影响他们的资...

-

使用Pandas实现Excel中的数据透视表的项目实践

引言在数据分析中,数据透视表是一种非常强大的工具,它可以帮助我们快速汇总、分析和可视化大量数据。虽然excel提供了内置的数据透...

-

Pandas利用主表更新子表指定列小技巧

一、前言工作的小技巧,利用pandas读取主表和子表,利用主表的指定列,更新子表的指定列。案例:主表:uidname0...

-

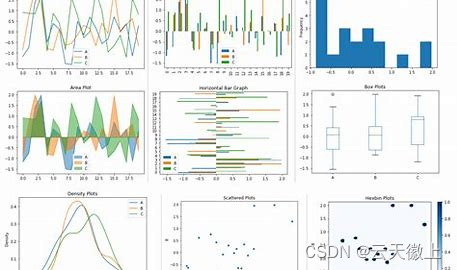

Pandas中统计汇总可视化函数plot()的使用

-

Python中tensorflow的argmax()函数的使用小结

在tensorflow中,argmax()函数是一个非常重要的操作,它用于返回给定张量(tensor)沿指定轴的最大值的索引。这个...