Linux如何安装和使用 TensorFlow Serving 进行模型部署

近期有些网友想要了解的相关情况,小编通过整理给您分享一下。

在人工智能和机器学习领域,模型的训练只是第一步,如何将训练好的模型高效地部署到生产环境中,才是真正发挥其价值的关键。TensorFlow Serving 作为 TensorFlow 官方推出的高性能模型服务系统,能够帮助开发者轻松实现模型的部署和管理。本文将详细介绍如何在 Linux 系统上安装和使用 TensorFlow Serving 进行模型部署。

一、TensorFlow Serving 简介

TensorFlow Serving 是一个灵活、高性能的机器学习模型服务系统,专为生产环境设计。它支持多种模型格式,包括 TensorFlow SavedModel、Keras 模型等,并提供了 RESTful API 和 gRPC 接口,方便客户端调用。通过 TensorFlow Serving,开发者可以快速将模型部署到生产环境中,实现高效的推理服务。

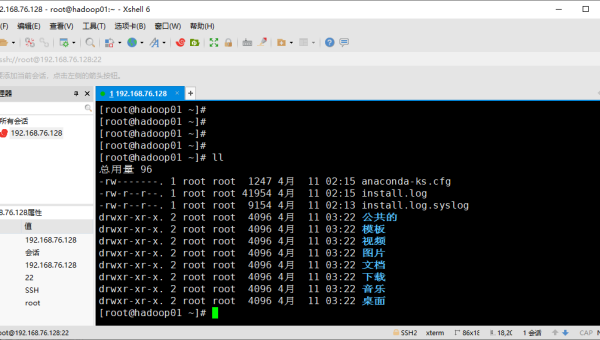

二、Linux 系统环境准备

在开始安装 TensorFlow Serving 之前,确保你的 Linux 系统满足以下条件:

- 操作系统:Ubuntu 18.04 或更高版本,CentOS 7 或更高版本。

- Python 版本:Python 3.6 或更高版本。

- TensorFlow 版本:TensorFlow 2.x。

1. 更新系统包

首先,更新系统包以确保所有软件都是最新版本:

sudo apt-get updatesudo apt-get upgrade2. 安装依赖项

安装 TensorFlow Serving 所需的依赖项:

sudo apt-get install -y curl gnupg三、安装 TensorFlow Serving

TensorFlow Serving 可以通过多种方式安装,这里我们介绍两种常用的方法:通过 Docker 安装和通过 APT 安装。

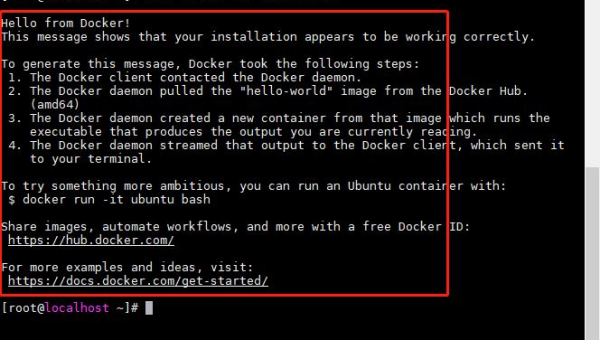

1. 通过 Docker 安装

Docker 是一种轻量级的容器技术,能够简化 TensorFlow Serving 的安装和部署过程。

1.1 安装 Docker

首先,安装 Docker:

sudo apt-get install -y docker.io1.2 拉取 TensorFlow Serving 镜像

拉取 TensorFlow Serving 的官方 Docker 镜像:

docker pull tensorflow/serving1.3 启动 TensorFlow Serving 容器

假设你已经有一个训练好的模型,保存在 /path/to/your/model 目录下,可以通过以下命令启动 TensorFlow Serving 容器:

docker run -p 8501:8501 --name tf_serving --mount type=bind,source=/path/to/your/model,target=/models/my_model -e MODEL_NAME=my_model -t tensorflow/serving2. 通过 APT 安装

如果你更倾向于直接安装 TensorFlow Serving,可以通过 APT 包管理器进行安装。

2.1 添加 TensorFlow Serving 的 APT 源

首先,添加 TensorFlow Serving 的 APT 源:

echo "deb [arch=amd64] http://storage.googleapis.com/tensorflow-serving-apt stable tensorflow-model-server tensorflow-model-server-universal" | sudo tee /etc/apt/sources.list.d/tensorflow-serving.listcurl https://storage.googleapis.com/tensorflow-serving-apt/tensorflow-serving.release.pub.gpg | sudo apt-key add -2.2 安装 TensorFlow Serving

更新 APT 包列表并安装 TensorFlow Serving:

sudo apt-get updatesudo apt-get install tensorflow-model-server2.3 启动 TensorFlow Serving

启动 TensorFlow Serving 服务:

tensorflow_model_server --port=8501 --rest_api_port=8502 --model_name=my_model --model_base_path=/path/to/your/model四、模型部署与测试

1. 模型准备

确保你的模型已经导出为 TensorFlow SavedModel 格式。SavedModel 是 TensorFlow 推荐的模型保存格式,能够包含模型的架构、权重和计算图等信息。

2. 部署模型

将模型目录挂载到 TensorFlow Serving 中,并启动服务。具体命令见上文。

3. 测试模型

通过 RESTful API 或 gRPC 接口调用模型进行推理测试。

3.1 RESTful API 测试

使用 curl 命令发送 POST 请求到 TensorFlow Serving 的 RESTful API 接口:

curl -X POST http://localhost:8501/v1/models/my_model:predict -d '{"instances": [1.0, 2.0, 5.0]}'3.2 gRPC 接口测试

使用 gRPC 客户端调用模型进行推理。你可以使用 Python 编写一个简单的 gRPC 客户端:

import grpcimport tensorflow as tffrom tensorflow_serving.apis import predict_pb2from tensorflow_serving.apis import prediction_service_pb2_grpcchannel = grpc.insecure_channel('localhost:8500')stub = prediction_service_pb2_grpc.PredictionServiceStub(channel)request = predict_pb2.PredictRequest()request.model_spec.name = 'my_model'request.model_spec.signature_name = 'serving_default'request.inputs['input'].CopyFrom(tf.make_tensor_proto([1.0, 2.0, 5.0], shape=[1, 3]))response = stub.Predict(request, 10.0)print(response.outputs['output'].float_val)五、优化与扩展

1. 性能优化

通过调整 TensorFlow Serving 的配置参数,如线程数、批处理大小等,可以进一步提升模型的推理性能。

2. 模型版本管理

TensorFlow Serving 支持多版本模型的管理,可以通过指定模型版本来实现模型的平滑升级和回滚。

3. 高可用性部署

在生产环境中,建议使用 Kubernetes 或 Docker Swarm 等容器编排工具,实现 TensorFlow Serving 的高可用性部署。

六、总结

通过本文的介绍,你应该已经掌握了在 Linux 系统上安装和使用 TensorFlow Serving 进行模型部署的基本方法。TensorFlow Serving 作为一个强大的模型服务系统,能够帮助开发者快速将训练好的模型部署到生产环境中,实现高效的推理服务。希望本文能够为你在实际项目中应用 TensorFlow Serving 提供有价值的参考。